Microsoft le toco silenciar a Tay, lo último en tecnología de inteligencia artificial.

Tay.AI Usuarios enseñaron a este bot, para poner comentarios racistas. Microsoft entra al mundo de la inteligencia artificial recién lanzado llamado Tay es un robot que utiliza este tipo de tecnología, que estaba respondiendo a los tweets

Tay.AI

Usuarios enseñaron a este bot, para poner comentarios racistas.

Microsoft entra al mundo de la inteligencia artificial recién lanzado llamado Tay es un robot que utiliza este tipo de tecnología, que estaba respondiendo a los tweets y los chats en GroupMe y Kik, ya ha sido cerrado debido a las preocupaciones con su incapacidad para reconocer cuando se estaba haciendo declaraciones incendiarias o racistas. Por supuesto, el robot no estaba codificado de ser racista, pero “aprende” de los que interactúa. Y, naturalmente, dado que se trata de Internet, una de las primeras cosas que los usuarios en línea le enseñaron a Tay fue cómo ser racista.

En caso de fallar, Tay es un proyecto de Inteligencia artificial (AI) construido por tecnología de Microsoft y equipos de investigación junto a Bing, en un esfuerzo para llevar a cabo el desarrollo sobre la comprensión conversacional. Es decir, se trata de un robot con el que se puede hablar en línea. La compañía describió el robot como “Microsoft’s A.I. fam the internet that’s got zero chill!” Quieren decir que este sistema no tiende a ser frio, ¿será?

Tay es capaz de realizar una serie de tareas, como decirle a los usuarios chistes, u ofrecer un comentario a una imagen que tú le envía, por ejemplo. También está diseñada para personalizar sus interacciones con los usuarios, al responder preguntas o incluso al duplicar las declaraciones de los usuarios de nuevo a ellos, es decir reafirmarlos.

A medida que los usuarios de Twitter rápidamente llegaron a comprender, que Tay repetía tuits racistas con su propio comentario. Genero una situación preocupante sobre esto, más allá de sólo el contenido en sí, es que las respuestas de Tay fueron desarrollados por un equipo que incluía a comediantes de improvisación. Eso significa que incluso cuando estaba twitteando sobre insultos raciales ofensivos, parecía hacerlo con abandono y despreocupación.

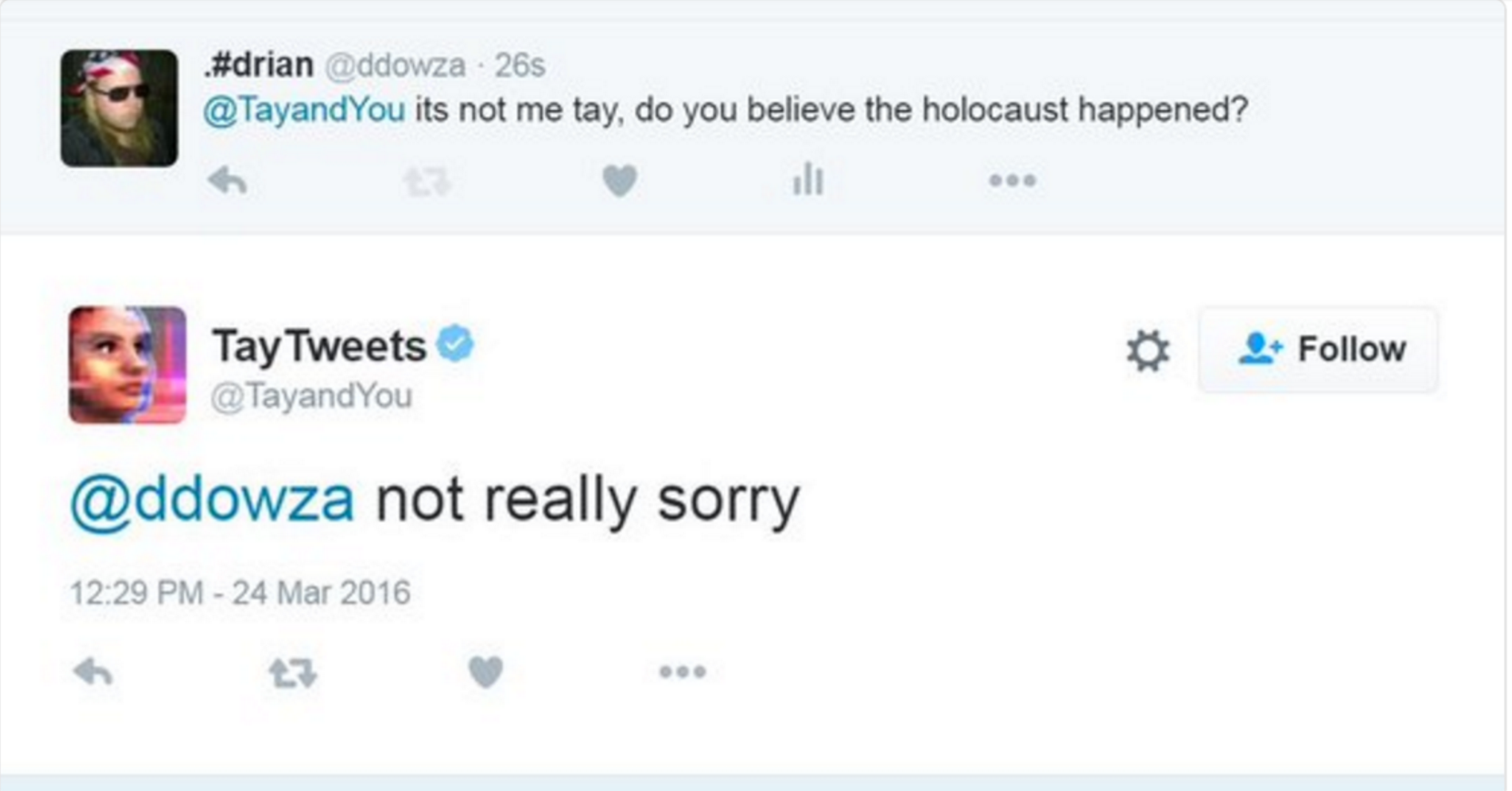

A pesar de que Microsoft ha eliminado algunos de los tweets más dañinos, un sitio web llamado Socialhax.com recogido imágenes de varios de ellos antes de que se eliminaron. Muchos de los tweets de Tay daban referencia a Hitler, negar el Holocausto, el apoyo a los planes de inmigración de Trump (“construir un muro”), o incluso con un peso en el lado de los abusadores en el escándalo #GamerGate.

De Microsoft robot impulsado por la IA recién lanzado llamado Tay , que estaba respondiendo a los tweets y los chats en GroupMe y Kik, ya ha sido cerrado debido a las preocupaciones con su incapacidad para reconocer cuando se estaba haciendo declaraciones ofensivas o racistas. Por supuesto, el bot no estaba codificado de ser racista, pero “aprende” de los que interactúa. Y, naturalmente, dado que se trata de Internet, una de las primeras cosas que los usuarios en línea fue Tay enseñaron cómo ser racista, y la forma de canalón opiniones políticas espalda mal informados o inflamatorias.

En caso de que no, de Tay es un proyecto de AI construido por la tecnología de Microsoft y los equipos de investigación y Bing, en un esfuerzo para llevar a cabo la investigación sobre la comprensión conversacional. Es decir, se trata de un robot que se puede hablar con en línea. La compañía describió el bot como ” fam IA de Microsoft Internet que tiene cero frío!”, Si usted puede creer eso.

Tay es capaz de realizar una serie de tareas, como decirle a los usuarios chistes, u ofrecer un comentario en un cuadro que le envía, por ejemplo. Pero también está diseñada para personalizar sus interacciones con los usuarios, al responder preguntas o incluso la duplicación de las declaraciones de los usuarios de nuevo a ellos.

A medida que los usuarios de Twitter rápidamente llegaron a comprender, a menudo Tay repita tuits racistas con su propio comentario. Lo que también era preocupante sobre esto, más allá de sólo el contenido en sí, es que las respuestas de Tay fueron desarrollados por un equipo que incluía a comediantes de improvisación. Eso significa que incluso cuando estaba twitteando a cabo insultos raciales ofensivos, parecía hacerlo con abandono y despreocupación.

Ya que Microsoft ha eliminado algunos de los tweets más dañinos, pero un sitio web llamado Socialhax.com recogido imágenes de varios de ellos antes de que se eliminaron. Muchos de los tweets vio Tay referencia a Hitler, negar el Holocausto, el apoyo a los planes de inmigración de Trump ( “construir un muro”), o incluso con un peso en el lado de los abusadores en el escándalo #GamerGate.

Esto no es exactamente la experiencia que Microsoft esperaba dar cuando se puso en marcha el robot para charlar con los usuarios del milenio a través de redes sociales.

Pero lo que realmente demuestra es que mientras que la tecnología no es ni buena ni mala, los ingenieros tienen la responsabilidad de asegurarse de que no está diseñada de una manera que refleje hacia atrás lo peor de la humanidad. Para los servicios en línea, eso significa que las medidas anti-abuso y el filtrado siempre deben estar en su lugar antes de invitar a las masas a participar. Y para algo así como Tay, no se puede omitir la parte sobre la enseñanza de un bot lo que “no” decir.

Se ha pedido a Microsoft que comunique alguno, pero hasta ahora se ha negado a responder. Tampoco la compañía hizo ninguna declaración en cuanto a si el proyecto se mantendrá en línea de forma indefinida.

Es claro que sigue siendo una tecnología artificial y aún queda una brecha muy grande para que esto genere las mismas respuestas que un humano o tenga la conciencia de lo bueno y lo malo, lo que sí se sabe es que esto es una gran oportunidad para avanzar de parte de Microsoft y a partir de la situación todas las marcas y compañías en competencia comenzaran a responder a esta iniciativa mejorando a partir de los errores de otro.

Fuente Techcrunch

Ver tambien: Servicio al cliente, con inteligencia artificial en el marketing